Правильный аудит сайта необходимо проводить для того, чтобы понимать в каком состоянии он находится. Для всех специалистов не секрет, что процесс ранжирования может давать непредсказуемые результаты.

Изменения случаются после каждого нового обновления. Если раньше для достижения высокого рейтинга достаточно было наполнить текст несвязными ключевыми фразами, то теперь это время ушло навсегда. Многие компании ищут другие пути развития, чтобы не отставать в популярности.

Следует учитывать ряд важных факторов, которые определяет поисковая система. К таким относятся:

Чтобы значительно улучшить вышеперечисленные показатели. Следует регулярно проводить полный аудит качества сайта. Однако произвести такую аналитику за короткое время невозможно, на это потребуется несколько часов. Прежде всего, это будет зависеть от объемов информации на сайте. При определенных параметрах на аудит придется потратить несколько дней.

При выполнении такой работы специалисты допускают некоторые ошибки, за счет которых сайт быстро теряет свой рейтинг. Сегодня мы рассмотрим 4 основные ошибки.

Прежде чем начать диагностику проблем на сайте необходимо понять, с чем конкретно вы имеете дело. Важность представляет полная и поэтапная аналитика. Этот этап необходимо проводить перед внесением каких-либо изменений. В противном случае модернизация будет бесполезной.

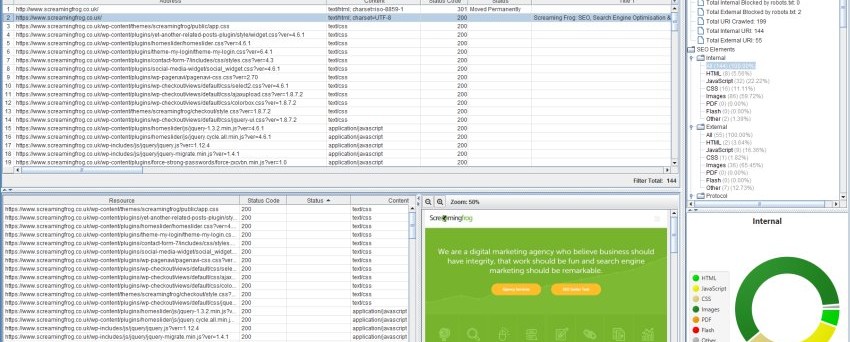

Если неизвестна точная техника аудита, то следует выбрать правильную программу сканирования. Для таких целей подходит – Screaming Frog’s Spider. Такой инструмент имеет огромную популярность, потому что использовать его наиболее просто, к тому же он имеет бюджетную стоимость.

В поле необходимо ввести ресурс.

Такой процесс необходимо проводить в самом начале аудита, как первый шаг, чтобы безупречно выполнить оставшуюся часть задач.

Когда для поисковых систем и простых пользователей сайт недоступен, весь труд, вложенный вами в разработку и наполнение контентом, будет безрезультатным. Чтобы не упустить такую возможность следует обеспечить для таких систем и пользователей быстрый доступ.

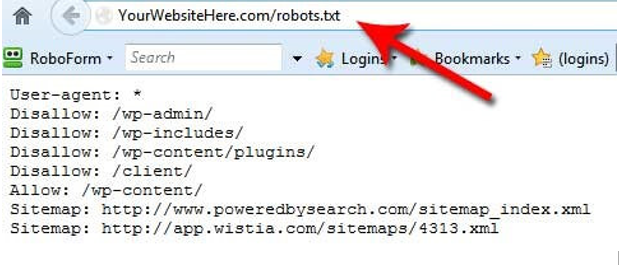

При помощи robots.txt можно указать файлы, которые доступны для сканирования. Такая возможность позволяет индексировать не все файлы, что облегчает загрузку сайта.

На изображении, которое указано выше можно заметить, что пользователь ограничил доступ к некоторым файлам. Производя такие действия, следует внимательно пересмотреть, потому, что можно случайно ограничить доступ к важным разделам. Подобная халатность негативным образом отражается на рейтинге сайта. А также некоторые станицы блокируют для доступа поисковой системы.

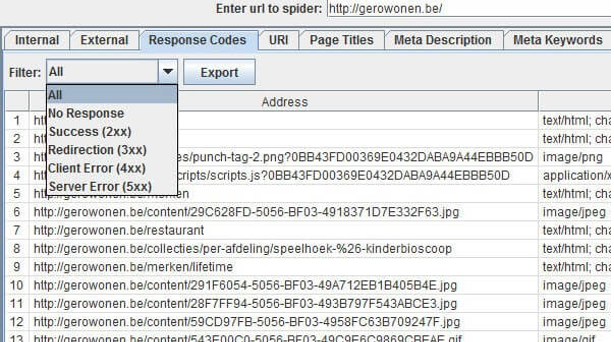

При сканировании можно обнаружить ряд наиболее популярных ошибок. Для ознакомления взгляните на изображение ниже.

Основной список:

Чтоб провести правильную аналитику, следует ознакомиться со всеми типами переадресаций. Существует несколько способов для решения проблемы при ошибке – 404. Для начала необходимо перенаправить посетителя на новую страницу. Если на удаленных страницах содержался ценный для поисковиков материал, то возникает необходимость в их восстановлении.

Ошибка 404 не может причинить особо вреда для сайта, но, тем не менее, негативно влияет на его работу. Чтобы не допустить таких ситуаций необходимо как минимум 1 раз за месяц контролировать процесс. При наличии крупного сайта с большими объемами информации аналитику нужно проводить 1 раз в неделю.

503 ошибка свидетельствует о сбоях в функционировании сервера. Такая ошибка используется, когда возникает необходимость предупредить поисковики о временной остановке работы сервера и пригласить вернуться позже.

Кроме таких сбоев, необходимо тщательно контролировать работу XML Sitemap. Это важно для того, чтобы на вашем ресурсе было легко найти любые страницы, если количество их составляет более 6 тысяч. Однако нужно правильно определить формат, иначе поисковики не смогут распознать вашу страницу.

Каждый владелец сайта должен периодически осуществлять полный мониторинг работы, такие действия являются обязательными. Обычно пользователи привыкли ожидать открытия страницы на протяжении 8-10 секунд. Точно так же и поисковые системы, у них отведено определенное количество времени на каждый сайт. Чем стремительнее происходит загрузка, тем больше вероятности успешного индексирования.

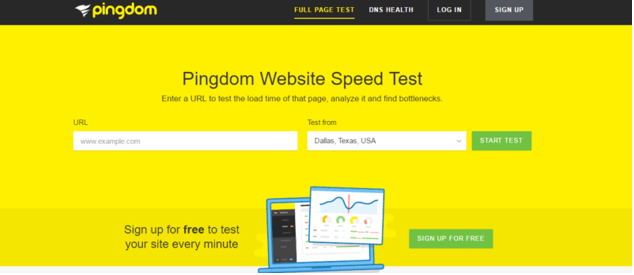

Чтобы протестировать скорость необходимо воспользоваться системой – Pingdom. Для некоторых стран этот инструмент недоступен, поэтому необходимо сменить ip адрес.

С помощью такой аналитики вы получите подробную информацию о том, что происходит на вашем сервере. Это позволяет определить факторы, которые влияют на скорость загрузки страниц. Кроме того, при помощи такого инструмента вы сможете получить варианты решения проблем и улучшить загрузку сайта.

Свободный доступ является ключевым фактором для оптимизации работы ресурса. Если вы отнесетесь к этому пункту без особого внимания, то популярность неизбежно упадет.

На сайте имеется множество элементов, рассматривать которые следует с особой тщательностью, особенно если они касаются ранжирования. Для начала стоит обратить внимание на содержание контента и подзаголовки, которые и приводят на страницу. Именно такие факторы и влияют на количество посещений пользователей. В этой ситуации стоит отдать предпочтение разработке уникального и качественного контента.

Если рассматривать проблему со стороны SEO, необходимо учитывать следующее:

Стоит обратить внимание на такие моменты, которые наносят непоправимый вред сайту:

А также необходимо тщательно поработать над URL, длина должна быть не более 110 – 115 символов. Страницу следует описывать кратко и емко.

Контент с другими источниками связывают при помощи внешних ссылок. Поэтому следует внимательно пересмотреть, на какой материал они ведут. Во время аудита вы должны проанализировать эти источники и убедиться, что они действительно заслуживают доверия.

При использовании такой стратегии сайт можно обнаружить в соцсетях. После аналитики учетной записи, источник по праву считается проверенным.

Если упустить даже один из этих факторов, то такая халатность негативно скажется на работе вашего ресурса. Чтобы впоследствии восстановить рейтинг потребуется вложение средств.

Даже те факторы, которые исходят из внешних источников, не следует игнорировать. Потому что они представляют не меньшую важность для развития и рейтинга вашего ресурса. Необходимо с особой аккуратностью вставлять различные ссылки. Потому что поисковики тщательно сортируют спам и большое количество ссылок на сайте.

Определить общую популярность ресурса можно при помощи аналитики Google. Чтобы контролировать свой трафик, контролируйте данные на постоянной основе. Такие действия помогут избежать внезапных потерь рейтинга.

Кроме того, следует провести конкурентную аналитику, чтобы выявить зависимость контента от каких-либо платформ. Далее можно определить степень популярности сайта и целевую аудиторию при помощи вспомогательных инструментов.

Выявить популярность того или иного ресурса также можно по ссылкам с обратных источников. Для этого используют специальные инструменты.

Большую важность при определении рейтинга представляют данные, а точнее их достоверность. Рассматривая ссылки источников, которые ведут на ваш ресурс, стоит определить наиболее ненадежные, занимающиеся рассылкой спама.

Такие ресурсы отличают по красным отметкам, они означают:

Если вы получаете ссылку с такими проблемами, то ее необходимо срочно нейтрализовать.

Не менее важный фактор, который определяет популярность того или иного контента – социальное взаимодействие. Некоторые считают, что этот фактор играет в ранжировании второстепенную роль, однако SEO с каждым днем приобретает социальность.

Сейчас практически каждая платформа имеет свой способ выражения симпатии – лайки, твиты. Накопление такой социальной поддержки показывает степень взаимодействия. Каждый человек в современном мире пользуется социальными сетями, и такая тенденция лишь возрастает ежегодно. Поэтому любой владелец сайта должен учитывать этот факт.

Также стоит обратить внимание и на то, какой целевой аудитории вы готовы предлагать товар. Если вашими потенциальными клиентами являются молодые люди до 30 лет, то взаимодействие с социальными сетами – это крайне обязательный шаг.

Большинство поисковиков регулярно обновляют алгоритм своей системы, пользователей при этом не оповещают. Поэтому необходимо все время следить за возникающими тенденциями, анализировать обновления. Проснувшись утром, за чашечкой кофе можно найти лишние 15 минут на то, чтобы изучить последние новости в сфере SEO. Чтобы действительно добиться популярности своего ресурса, не стоит отставать и терять бдительность.

SEO кейсы от НАС!

Комментарии к статье