Сервисы по сканированию сайтов на технические SEO-ошибки являются незаменимыми инструментами для SEO-специалистов и для владельцев сайтов, но тут еще необходимы знания и опыт в SEO, чтобы определить, какие предупреждения следует учитывать, а какие игнорировать.

Во многих случаях то, что поисковый робот отмечает как фатальную ошибку, требует немедленного внимания, но иногда это вовсе не ошибка. Это может произойти даже с самыми популярными инструментами SEO сканирования, такими как Semrush, Netpeak Spider, Ahrefs, Screaming Frog и другими.

Мы подготовили несколько реальных примеров таких предупреждений и ошибок вместе с объяснением того, почему они не обязательно будут проблемой для вашего веб-сайта.

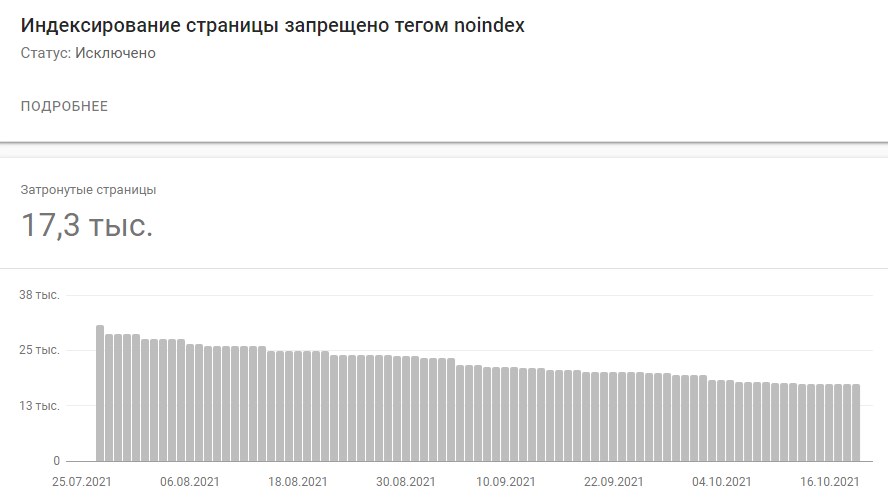

Любой поисковый робот выделит и предупредит вас о неиндексируемых страницах на сайте. В зависимости от типа поискового робота страницы noindex могут быть помечены как предупреждения или ошибки.

Отчет о покрытии Google Search Console может также помечать неиндексируемые страницы как ошибки (если сайт имеет неиндексируемые страницы в отправленной .xml карте сайта) или исключенные, даже если они не являются актуальными проблемами.

Это, опять же, только информация о том, что эти URL-адреса не могут быть проиндексированы.

Вот как это выглядит в Google Search Console:

Тот факт, что URL-адрес содержит тег «noindex», не обязательно означает, что это ошибка. Это означает лишь то, что страница не может быть проиндексирована Google и другими поисковыми системами.

Практически каждый веб-сайт содержит URL-адреса, которые не должны индексироваться Google. Они могут включать, например, страницы тегов (а иногда и страницы категорий), страницы пагинации, страницы фильтров, страницы входа в систему, страницы сброса пароля или страницу благодарности.

Наша задача как специалистов по поисковому продвижению – просмотреть страницы noindex на сайте и решить, действительно ли они должны быть заблокированы от индексации или тег noindex мог быть добавлен случайно.

Поисковые SEO-сервисы также будут проверять мета теги сайта, включая тег “description”. Если на сайте нет метаописаний или они слишком короткие (обычно менее 110 символов), то поисковый робот пометит это как проблему.

В зависимости от размера сайта не всегда возможно и/или выполнимо создавать уникальные метаописания для всех его веб-страниц. Они могут вам и не понадобиться.

Хорошим примером сайта, на котором это может быть бессмысленно, является огромный сайт электронной коммерции с миллионами URL-адресов. Фактически, чем больше размер сайта, тем менее важным становится этот элемент. Содержимое элемента мета-описания, в отличие от содержимого тега заголовка, не принимается во внимание Google и не влияет на ранжирование.

В поисковых сниппетах иногда используется метаописание, но Google часто переписывает их, заменяя на данные из содержимого страницы.

Вот что Google говорит об этом в своей документации Advanced SEO:

«Сниппеты автоматически создаются из содержимого страницы. Сниппеты предназначены для выделения и предварительного просмотра содержимого страницы, которое лучше всего соответствует конкретному поиску пользователя: это означает, что на странице могут отображаться разные фрагменты для разных поисковых запросов».

В работе с SEO-оптимизацией ресурса нужно помнить, что каждый сайт индивидуален. Важно использовать здравый смысл, принимая решение, действительно ли метаописания являются проблемой для этого конкретного веб-сайта, или вы можете игнорировать данное предупреждение.

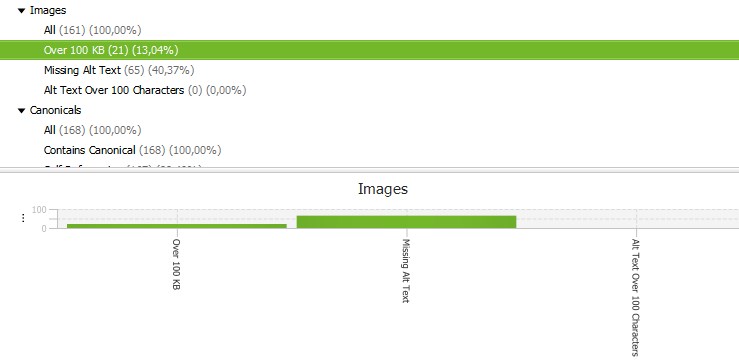

Важно оптимизировать и сжимать изображения, используемые на сайте, чтобы, например гигантский логотип в формате PNG весом 20 МБ не нужно было загружать на каждую веб-страницу.

Однако не всегда удается сжать все изображения до размера менее 100 КБ. Screaming Frog всегда выделяет и предупреждает об изображениях, размер которых превышает 100 КБ. Вот как это выглядит в инструменте:

Тот факт, что на сайте есть изображения размером более 100 КБ, не обязательно означает, что сайт имеет проблемы с оптимизацией изображений или работает очень медленно. При появлении этой ошибки обязательно проверьте общую скорость и производительность сайта в Google PageSpeed Insights и в отчете Core Web Vitals в Google Search Console. Если с сайтом все в порядке и он проходит оценку Core Web Vitals, то, как правило, нет необходимости в дальнейшем сжатии изображений.

Что вы можете сделать с этим отчетом Screaming Frog, так это отсортировать изображения по размеру от самых тяжелых до самых легких, чтобы проверить, есть ли действительно огромные изображения на определенных веб-страницах и если есть оптимизировать их.

В зависимости от настроек сканирований SEO-паука, большинство инструментов технического SEO-аудита выделяют страницы, содержащие менее 50–100 слов, как страницы с низким содержанием.

Screaming Frog, с другой стороны, считает, что страницы, содержащие менее 200 слов, по умолчанию являются страницами с низким содержанием (этот параметр можно изменить при настройке сканирования).

То, что на веб-странице мало слов, не означает, что это проблема или ошибка. Существует много типов страниц, на которых предполагается малое количество слов, включая некоторые страницы входа в систему, корзины, страницы сброса пароля или контактов.

Сканер будет отмечать эти страницы как страницы с низким содержанием, но это не проблема, которая помешает сайту хорошо ранжироваться в Google.

Инструмент пытается сказать вам, что если вы хотите, чтобы данная веб-страница имела высокий рейтинг в Google и приносила большой органический трафик, то эта веб-страница, возможно, должна иметь более расширенный текстово-графический контент.

Это часто включает, среди прочего, большое количество слов. Но существуют разные типы намерений поиска, и объем контента не всегда является тем, что пользователи ищут для удовлетворения своих потребностей.

При просмотре страниц с низким количеством слов, отмеченных поисковым роботом, всегда думайте о том, действительно ли на этих страницах должно быть много контента. Во многих случаях это не так.

Semrush Site Audit также предупредит вас о страницах с низким соотношением текста и HTML.

Это предупреждение должно показать вам:

Это предупреждение часто сбивает с толку менее опытных специалистов по SEO, и вам может потребоваться опытный технический SEO специалист, чтобы определить, есть ли в этом повод для беспокойства.

Существует множество переменных, которые могут повлиять на соотношение HTML-текста, и это не всегда проблема, если на сайте соотношение HTML-текста низкое/высокое. Оптимального соотношения HTML и текста не существует.

Вместо этого лучше сосредоточиться на обеспечении оптимальной скорости и производительности сайта.

Robots.txt, помимо того, что является файлом с директивами сканера, также является местом, где вы можете указать URL-адрес XML-карты сайта, чтобы Google мог легко сканировать ее и индексировать контент.

Сервисы для SEO-сканирования сайтов, например Semrush Site Audit, уведомят вас, если карта сайта XML не указана в robots.txt.

На первый взгляд, это выглядит серьезной проблемой, хотя в большинстве случаев это не так, потому что:

Прежде чем отмечать это как высокоприоритетную проблему, убедитесь, что ни одно из вышеперечисленного не соответствует действительности для вашего сайта.

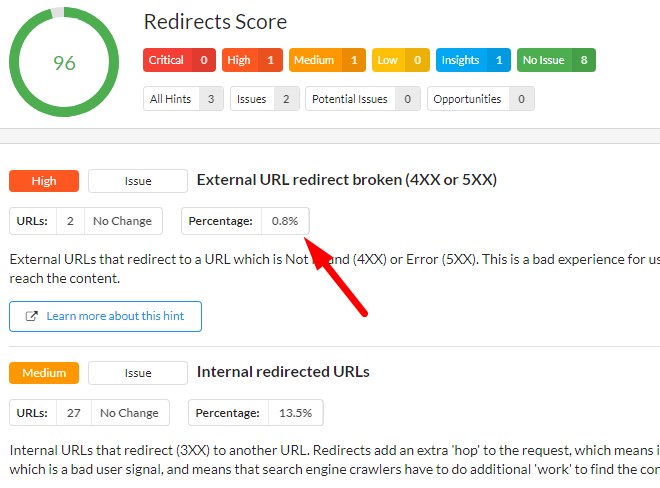

Даже если инструмент показывает реальную проблему, например страницу 404 на сайте, это может и не быть серьезной ошибкой, если это одна из миллионов веб-страниц на сайте или если нет ссылок, указывающих на эту 404 страницу.

Вот почему при оценке проблем, обнаруженных сканером, всегда нужно проверять, к скольким веб-страницам они относятся и к каким из них. Вам необходимо указать контекст ошибки.

Например, сервис Sitebulb покажет вам процент URL-адресов, к которым относится данная ошибка.

Вот пример перенаправления внутреннего URL-адреса на неработающий URL-адрес, возвращающий 4XX или 5XX, о котором сообщает Sitebulb:

Это выглядит довольно серьезной проблемой, но касается только двух веб-страниц, поэтому это определенно не является критической и приоритетной проблемой.

Сервисы по поисковому сканированию сайтов – незаменимые инструменты для технических SEO специалистов. Однако то, что они раскрывают, всегда следует интерпретировать в контексте веб-сайта и ваших бизнес-целей.

Чтобы отличить псевдо-проблему от реальной, нужно время и опыт. К счастью, большинство поисковых роботов предлагают подробные объяснения отображаемых ошибок и предупреждений.

Вот почему всегда полезно читать эти объяснения и документацию сервиса. Убедитесь, что вы действительно понимаете, что означает данная проблема и действительно ли стоит решать ее.

Главный редактор.

🔮 Google AI Mode, 🐦 Grok, 🔍 Perplexity, 💬 ChatGPT, 🤖 Claude.ai.

SEO кейсы от НАС!

SEO-оптимизация сайта под требования AI

SEO-оптимизация сайта под требования AI  9 примеров контента, которым захотят поделиться

9 примеров контента, которым захотят поделиться  Как Хорошоп.Export помогает украинским предпринимателям успешно реализовывать свои товары за границей

Как Хорошоп.Export помогает украинским предпринимателям успешно реализовывать свои товары за границей  Google E-E-A-T: как продемонстрировать личный опыт

Google E-E-A-T: как продемонстрировать личный опыт  Квиз – универсальный инструмент для лидогенерации

Квиз – универсальный инструмент для лидогенерации  Почему для бизнеса лучше создавать собственный Telegram-бот? Пример украинского стартапа BAZAR.club

Почему для бизнеса лучше создавать собственный Telegram-бот? Пример украинского стартапа BAZAR.club  8 советов по маркетингу в Facebook, которые помогут оживить скучную страницу

8 советов по маркетингу в Facebook, которые помогут оживить скучную страницу  Что такое целевая аудитория и как ее найти

Что такое целевая аудитория и как ее найти

Комментарии к статье