Одним з найважливіших факторів впливу на позиції сайту у видачі є його контентне наповнення. Безперечно, що як SEO-оптимізатори, так і самі власники сайтів, прагнуть до того, щоб наповнити веб-ресурс унікальним, якісним, цікавим контентом. Але існують і такі недоброзичливці, які просто «крадуть» інформацію з інших ресурсів і видають її як свою. Несправедливість полягає в тому, що після індексації дані сторінки можуть піднятися у видачі навіть вище, ніж сторінки з оригінальним текстом. Але існує і ряд маніпуляцій, здатних захистити контент від копіювання з боку конкурентів і професійних монетизаторів. У цій статті розглянемо декілька найпопулярніших кроків.

Найвідомішим інструментом для копіювання контенту є система парсингу. Це автоматизована система, поведінка якої істотно відрізняється від поведінки реальних користувачів. Для захисту необхідно виявити серед відвідувачів автоматичний парсер і заблокувати його на рівні сервера.

Тут пропонується два способи:

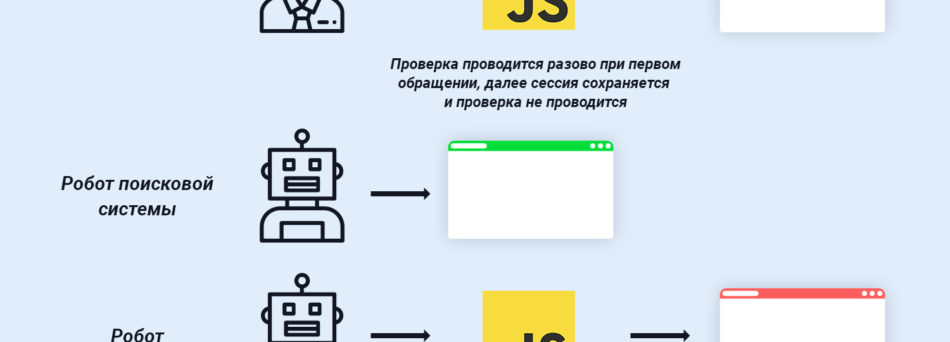

Перевірка на JavaScript. Системи парсингу дуже просто розпізнати за допомогою перевірки на використання JavaScript. Якщо ж скрипт не виконується, то висока ймовірність того, що Ваш ресурс відвідує робот. У тому випадку, якщо Ви розраховуєте, що все-таки існує ймовірність того, що сайт буде відвідувати юзер з повністю відключеним JavaScript, то логічним стає підключення до сайту інструменту проходження капчі.

Також варто взяти до уваги і краулерів пошукових систем, і виключити їх з блокування. Списки краулерів представлені на офіційних сайтах пошукових систем.

Перевірка на дію. Сучасні розробники систем парсингу навчилися створювати інструменти, що імітують включений JavaScript. У таких випадках, вищеописані способи не зможуть ідентифікувати робота. Для того, щоб заблокувати такі системи парсингу, варто визначити головні цілі його роботи. А це – сканування та копіювання цінного контенту. Шляхом аналізу логів сервера відбувається збір IP-адрес парсерів. Наступний крок – блокування доступу до сайту. Для цього використовується файл директив сервера .htaccess.

Крім описаних вище способів можна ще скористатися алгоритмами, які аналізують швидкість кліка, провести «тест на клік», аналіз руху курсора.

Більшість сучасних сайтів мають встановлену генерацію карти сайту sitemap.xml, куди вноситься список посилань на сторінки, що підлягають індексації. Основне завдання карти сайту – оповіщення ПС, про появу нових сторінок.

Але трапляються ситуації, коли автоматизовані системи парсингу дізнаються, про появу нової сторінки раніше, ніж роботи пошукових систем. Це дозволяє скопіювати новий контент і опублікувати його на сайті з копіями. Далі проводиться прискорена індексація сторінок (наприклад за допомогою інструменту GetSocial) і пошукові роботи визначають копію, як оригінал.

На щастя, пошуковим системам давно відомі дані схеми роботи парсерів і вони пропонуються скористатися спеціальними інструментами – Google Search Console Sitemaps і Yandex Webmaster.

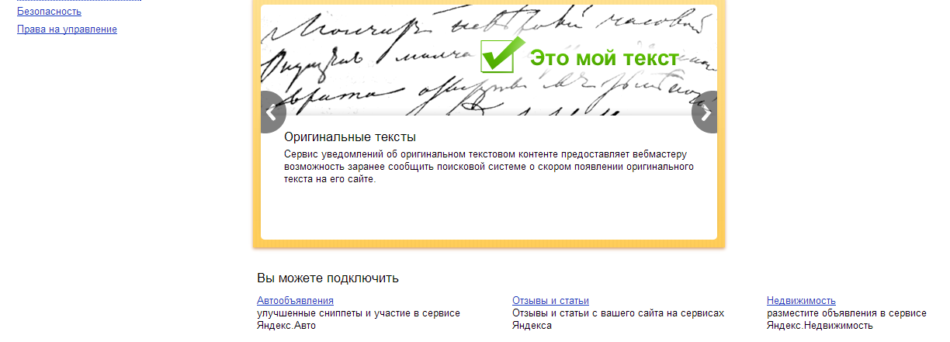

Пошукова система Яндекс пропонує скористатися спеціальним інструментом для повідомлення про появу нового оригінального тексту на сайті. Він так і називається «Оригінальні тексти». Перед тим, як завантажити текст на сам сайт, завантажуємо його в систему, для того, щоб при ранжуванні результатів враховувалося саме джерело оригінального контенту.

На жаль, ПС Google не пропонує подібних інструментів, але зате передбачена можливість видалення сторінок конкурентів, на яких розміщений скопійований текст. Для цього в сфері Інтернет-маркетингу існує таке поняття, як DMCA (THE DIGITAL MILLENNIUM COPYRIGHT ACT Summary). Закон, прийнятий в США в області авторського права для захисту контенту на цифрових носіях, в тому числі і в Інтернеті. Відповідно до закону кожен користувач має повне право звернутися в Google і подати запит на видалення сторінки з неоригінальним контентом.

Перевірити текст на вже існуючі копії можна, скориставшись спеціальним безкоштовним сервісом MegaIndex. Також передбачена можливість, що дозволяє відстежувати появу нових копій контенту з моніторингу спогадів. Але для цього буде потрібно вказувати, наприклад, назву компанії чи бренду в кожній статті, яка публікується на сайті. Надалі для відстеження репутації сайту в Інтернеті можна відстежувати згадки про компанію, таким чином, ідентифікуючи появу нових копій Вашого контенту. Тут задіюється сервіс MegaIndex Search Engine Reputation Management.

Унікальний, оригінальний контент на сайті допоможе не просто поліпшити ранжування ресурсу і підвищити його позиції у видачі. Це також відмінний інструмент залучення цільової аудиторії, яка в подальшому перетворюється в потенційного клієнта. Одним з найважливіших етапів просування від компанії є наповнення ресурсу унікальним контентом і комплекс заходів по захисту його від копіювання конкурентами.

Головний редактор.

🔮 Google AI Mode, 🐦 Grok, 🔍 Perplexity, 💬 ChatGPT, 🤖 Claude.ai.

SEO кейси від НАС!

SEO-оптимізація сайту під вимоги AI

SEO-оптимізація сайту під вимоги AI  9 прикладів контенту, яким захочуть поділитися

9 прикладів контенту, яким захочуть поділитися  Як Хорошоп.Export допомагає українським підприємцям успішно реалізовувати свої товари за кордоном

Як Хорошоп.Export допомагає українським підприємцям успішно реалізовувати свої товари за кордоном  Google E-E-A-T: як продемонструвати особистий досвід

Google E-E-A-T: як продемонструвати особистий досвід  Квіз - універсальний інструмент для лідогенерації

Квіз - універсальний інструмент для лідогенерації  Чому для бізнесу краще створювати власний Telegram-бот? Приклад українського стартапу BAZAR.club

Чому для бізнесу краще створювати власний Telegram-бот? Приклад українського стартапу BAZAR.club  8 порад з маркетингу у Facebook, які допоможуть оживити нудну сторінку

8 порад з маркетингу у Facebook, які допоможуть оживити нудну сторінку  Що таке цільова аудиторія та як її знайти

Що таке цільова аудиторія та як її знайти

Коментарі до статті