Правильний аудит сайту необхідно проводити для того, щоби розуміти, в якому стані він знаходиться. Для всіх фахівців не секрет, що процес ранжування може давати непередбачувані результати.

Зміни трапляються після кожного нового оновлення. Якщо раніше для досягнення високого рейтингу досить було наповнити текст незв’язними ключовими фразами, то зараз цей період втрачено назавжди. Багато компаній шукають інші шляхи розвитку, щоби не відставати в популярності.

Слід враховувати ряд важливих факторів, які визначає пошукова система. До таких відносяться:

Щоб значно поліпшити вище перелічені показники, слід регулярно проводити повний аудит якості сайту. Однак зробити таку аналітику за короткий час неможливо, для цього знадобиться кілька годин. Перш за все витрачений час залежатиме від обсягів інформації на сайті. При певних параметрах на аудит доведеться витратити декілька днів.

При виконанні такої роботи фахівці допускаються деяких помилок, за рахунок яких сайт швидко втрачає свій рейтинг. Сьогодні ми розглянемо 4 основні помилки.

Перш ніж почати діагностику проблем на сайті, необхідно зрозуміти, з чим конкретно ви маєте справу. Важливості надає повна і поетапна аналітика. Цей етап необхідно проводити перед внесенням будь-яких змін. В іншому випадку модернізація буде марною.

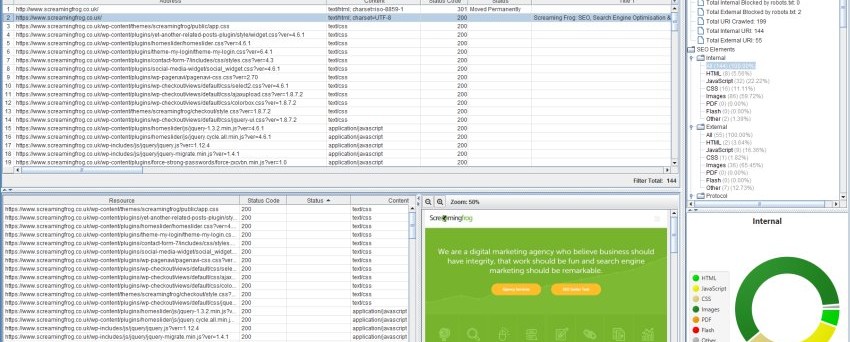

Якщо невідома точна техніка аудиту, то слід вибрати правильну програму сканування. Для таких цілей підходить – Screaming Frog’s Spider. Такий інструмент має величезну популярність, тому що використовувати його найпростіше, до того ж він має бюджетну вартість.

В полі необхідно ввести ресурс.

Цей процес необхідно проводити на початку аудиту, в якості першого кроку, щоби бездоганно виконати решту завдань.

Коли для пошукових систем і простих користувачів сайт недоступний, вся праця, вкладена вами в розробку та наповнення контентом, буде безрезультатним. Щоби не втратити таку можливість, слід забезпечити швидкий доступ для систем та користувачів.

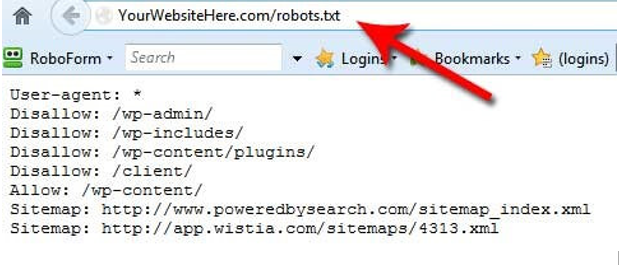

За допомогою robots.txt можна вказати файли, які доступні для сканування. Така можливість дозволяє індексувати не всі файли, що полегшує завантаження сайту.

На зображенні, зазначеному вище, можна помітити, що користувач обмежив доступ до деяких файлів. Виконуючи такі дії, слід уважно передивитись цей момент, тому що можна випадково обмежити доступ до важливих розділів. Подібна недбалість негативним чином відображається на рейтингу сайту. Також деякі сторінки блокують для доступу пошукової системи.

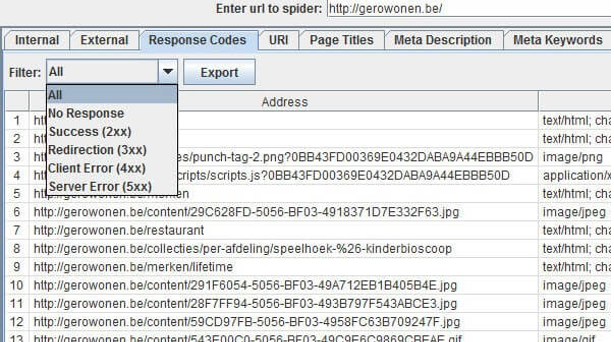

При скануванні можна виявити ряд найбільш популярних помилок. Для ознайомлення подивіться на зображення, розміщене нижче.

Основний список:

Щоби провести правильну аналітику, слід ознайомитися з усіма типами перенаправлень. Існує кілька способів для вирішення проблеми при помилку – 404. Для початку необхідно перенаправити відвідувача на нову сторінку. Якщо на віддалених сторінках містився цінний для пошукових систем матеріал, то виникає необхідність в їх відновленні.

Помилка 404 не може заподіяти значної шкоди для сайту, але, тим не менш, негативно впливає на його роботу. Щоб не припускати таких ситуацій, необхідно як мінімум 1 раз за місяць контролювати процес. При наявності великого сайту з великими обсягами інформації аналітику потрібно проводити 1 раз в тиждень.

503 помилка свідчить про збої у функціонуванні сервера. Така помилка використовується, коли виникає необхідність попередити пошуковики про тимчасове зупинення роботи сервера і запросити повернутися пізніше.

Крім таких збоїв, необхідно ретельно контролювати роботу XML Sitemap. Це є важливим для того, щоб на вашому ресурсі було легко знайти будь-які сторінки, якщо кількість їх становить понад 6 тисяч. Однак потрібно правильно визначити формат, інакше пошукові системи не зможуть розпізнати вашу сторінку

Кожен власник сайту повинен періодично здійснювати повний моніторинг роботи, такі дії є обов’язковими. Зазвичай користувачі звикли очікувати відкриття сторінки протягом 8-10 секунд. Точно так само діють і пошукові системи — у них відведено певну кількість часу на кожен сайт. Чим стрімкіше відбувається завантаження, тим більше вірогідності успішного індексування.

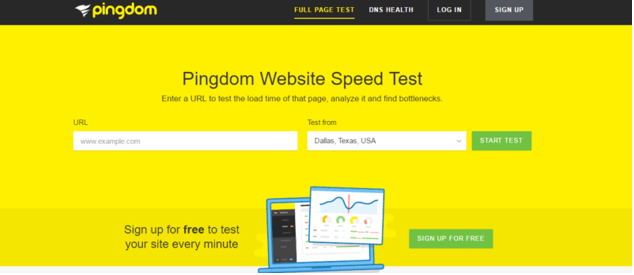

Щоб протестувати швидкість, необхідно скористатися системою – Pingdom. Для деяких країн цей інструмент недоступний, тому необхідно змінити ip адресу.

За допомогою такої аналітики ви отримаєте детальну інформацію про те, що відбувається на вашому сервері. Це дозволяє визначити фактори, які впливають на швидкість завантаження сторінок. Крім того, за допомогою такого інструменту ви зможете отримати варіанти рішення проблем і поліпшити завантаження сайту.

Вільний доступ є ключовим фактором для оптимізації роботи ресурсу. Якщо ви поставитеся до цього пункту без особливої уваги, то популярність сайту неминуче впаде.

На сайті є безліч елементів, розглядати які слід з особливою ретельністю, особливо якщо вони стосуються ранжування. Для початку варто звернути увагу на зміст контенту та підзаголовки, які ведуть на сторінку. Саме такі фактори впливають на кількість відвідувань користувачів. У цій ситуації варто віддати перевагу розробці унікального і якісного контенту.

Якщо розглядати проблему з боку SEO, необхідно враховувати наступне:

Варто звернути увагу на такі моменти, які завдають непоправної шкоди сайту:

А також необхідно ретельно попрацювати над URL, їх довжина повинна складати не більше 110 – 115 символів. Сторінку слід описувати коротко та змістовно.

Контент з іншими джерелами пов’язують за допомогою зовнішніх посилань. Тому слід уважно переглянути, на який матеріал вони ведуть. Під час аудиту ви повинні проаналізувати ці джерела і переконатися, що вони дійсно заслуговують довіри.

При використанні такої стратегії сайт можна виявити в соцмережах. Після аналітики облікового запису, джерело по праву вважається перевіреним.

Якщо випустити з уваги навіть один з цих факторів, то така недбалість негативно позначиться на роботі вашого ресурсу. Щоби згодом відновити рейтинг, знадобиться вкладення коштів.

Навіть ті фактори, які виходять із зовнішніх джерел, не слід ігнорувати, тому що вони представляють не меншу важливість для розвитку та рейтингу вашого ресурсу. Необхідно з особливою акуратністю вставляти різні посилання. Тому що пошукові системи ретельно сортують спам і велику кількість посилань на сайті.

Визначити загальну популярність ресурсу можна за допомогою аналітики Google. Щоб контролювати свій трафік, контролюйте дані на постійній основі. Такі дії допоможуть уникнути раптових втрат рейтингу.

Крім того, слід провести конкурентну аналітику, аби виявити залежність контенту від будь-яких платформ. Далі можна визначити ступінь популярності сайту та цільову аудиторію за допомогою допоміжних інструментів.

Виявити популярність того чи іншого ресурсу також можна за посиланнями зі зворотніх джерел. Для цього використовують спеціальні інструменти.

Велику важливість при визначенні рейтингу представляють дані, а точніше їх достовірність. Розглядаючи посилання джерел, які ведуть на ваш ресурс, варто визначити найбільш ненадійні, що займаються розсилкою спаму.

Такі ресурси відрізняють за червоними позначками, які означають:

Якщо ви отримуєте посилання з такими проблемами, то їх необхідно терміново нейтралізувати.

Не менш важливим фактором, який визначає популярність того чи іншого контенту, є соціальна взаємодія. Дехто вважає, що цей фактор відіграє в ранжуванні другорядну роль, однак SEO з кожним днем набуває соціальності.

Зараз майже кожна платформа має свій спосіб вираження симпатії – лайки, твіти. Накопичення такої соціальної підтримки показує ступінь взаємодії. Кожна людина в сучасному світі використовує соціальні мережі, й така тенденція лише зростає щорічно. Тому будь-який власник сайту повинен враховувати цей факт.

Також варто звернути увагу й на те, якій цільової аудиторії ви готові пропонувати товар. Якщо вашими потенційними клієнтами є молоді люди до 30 років, то взаємодія із соціальними мережами — це обов’язковий крок.

Більшість пошукових систем регулярно оновлюють алгоритм своєї системи, не сповіщаючи при цьому користувачів. Тому необхідно весь час стежити за тенденціями, які виникають, та аналізувати оновлення. Прокинувшись вранці, можна знайти зайві 15 хвилин на те, щоб за чашкою кави вивчити останні новини в сфері SEO. Щоби дійсно досягти популярності свого ресурсу, не варто відставати в трендах та втрачати пильність.

🔮 Google AI Mode, 🐦 Grok, 🔍 Perplexity, 💬 ChatGPT, 🤖 Claude.ai.

SEO кейси від НАС!

Коментарі до статті